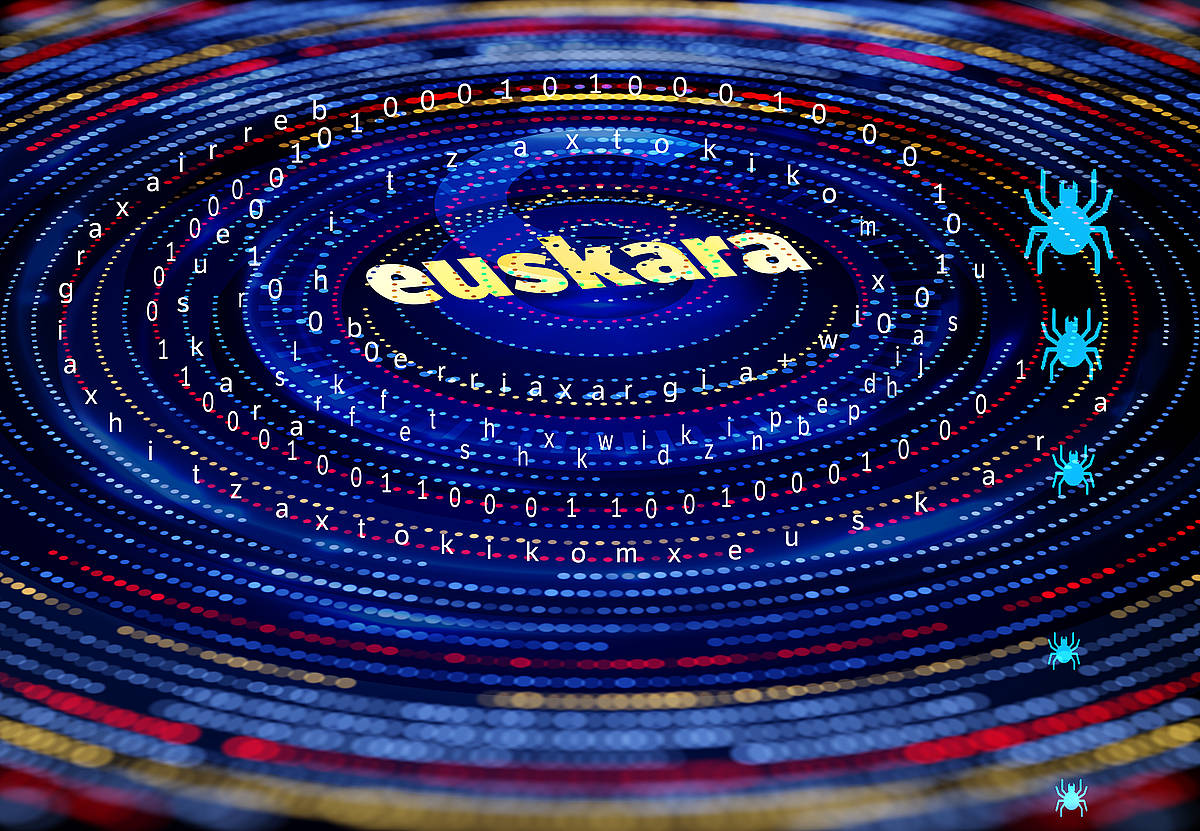

Euskarazko kalitate handiko corpusa sortu du EHUko Informatika fakultateko Ixa ikerketa taldeak: EusCrawl. Euskarazko hainbat komunikabideren edukietan oinarritu du, eta ondokoa izan da emaitza: 12,5 milioi dokumentu eta 423 milioi hitz. Corpusak funtsezkoak dira hizkuntzan oinarritutako aplikazioak sortzeko.

Gaur egungo herritarrak hizkuntzari lotutako aplikazio ugari ditu inguruan: sakelakoan edo ordenagailuan idazten ari dela hurrengo hitza izan daitekeena erakusten dutenak, hitzez galdetu eta erantzuten duten laguntzaile adimendunak (Alexa, Siri, Google Assistant...), bezeroen arretarako txatbotacloseTestu nahiz entzumen bidezko metodoen bitartez elkarrizketa bat jarraitzen duen programa informatikoa.k, itzultzaile automatikoak...

Gertuko, ohiko eta berehalako bihurtu diren aplikazio horien muinean, baina, itzaleko lana eta entrenamendua dago. Zehazki, adimen artifiziala, machine learning-a eta deep learning-a. Machine learning-a, ikasketa automatikoa, adimen artifizialaren adar bat da: algoritmoei datu pila bat ematen dizkiete, eta gai dira datu horietan patroiak, ereduak, identifikatzeko eta iragarpenak egiteko. Deep learning-a, ikasketa sakona, ikasketa automatiko mota bat da, sare neuronaletan oinarritua.

Testuen beharra

Teknologia horrek datu pila bat behar du, sistemak ikasteko eta entrenatzeko. Hizkuntzan oinarritutako teknologia denez, testuak eman behar zaizkio. Ixa taldeak kalitate handiko euskarazko corpus bat osatu du, eta eskura jarri du, nahi duenak erabil dezan: EusCrawl (ixa.ehu.eus/euscrawl). EHU Euskal Herriko Unibertsitateko ikerketa talde bat da Ixa. Hizkuntzaren tratamendu automatikoan lan egiten du.

Euskararen kasuan, hizkuntza gutxitua denez, zaila du testu corpus erraldoiak biltzea. Euskarazko corpusak badaude. Batzuk ez daude erabili nahi dituenaren eskura. Beste batzuk bai: «Facebookek, Googlek eta horiek sortuak», azaldu du Aitor Soroak, Ixa taldeko eta EHUko Informatika fakultateko irakasleak.

Googlerenak eta Meta AI-renak —lehen Facebook— dira euskarazko testu masarik handienak: Googlerena, mC4, mila milioi hitzekoa; Meta AIrena, CC100, 416 milioi hitzekoa. Haien kalitatea, baina, zalantzan jarri da, euskarazko edukiak bereizteko programa automatikoek hainbat akats egiten dituztelako.

Googlerenak eta Meta AI-renak dira euskarazko testu masa handienak: Googlerena, mC4, mila milioi hitzekoa; Meta AIrena, CC100, 416 milioi hitzekoa.

Komunikabideen egitekoa

Kalitate oneko euskarazko corpusa sortu du Ixak. Ez du, Interneteko erraldoien gisan, begi estuko sarea hartu eta Internet osoan arrantza egin, horrela euskarazkoak bai baina zaborra eta beste hizkuntza batzuetan dauden edukiak ere harrapatzen direlako. «Guk kontrakoa egin dugu», argitu du Soroak. «Aurrena iturri on batzuk identifikatu genituen; gero programa batzuk sortu genituen, haietatik informazioa xurgatzeko; eta horrela sortu da corpusa».

Edukiak Creative Commons lizentzia librearekin banatzen dituzten Interneteko zenbait webgune aukeratu zituzten, komunikabideak batez ere: Tokikom (tokiko 76 komunikabide biltzen dituen elkartea), BERRIA, eskualdeetako Hitza egunkariak, euskarazko Wikipedia, Argia eta Bilbo Hiria irratia. Haiek sortutako edukiak xurgatu egin zituzten —crawl, ingelesez—. Emaitza: EusCrawl. 12,5 milioi dokumentu eta 423 milioi hitz.

Ikasketa sakonaren barruan hizkuntza eredua deitutako teknika edo teknologia dago, sare neuronaletan oinarritua. Hizkuntza eredu horiek testuarekin entrenatzen dituzte: «Testua irakurtzen dute, hizkuntzaren patroiak ikusten dituzte, eta, milioika eta milioika hitz irakurriz, ikasi egiten dute. Horrela, hizkuntzari buruzko eredu matematiko erraldoi bat sortzen duzu. Hori bai, ondo idatzitako testuak eman behar zaizkio». Ez dute ikasi bakarrik egiten. Testu berriak sortzeko gai ere badira. Hizkuntza ereduek hizkuntzaren egitura egitura matematiko bihurtzen dute, nolabait esateko.

«Hizkuntzari buruzko eredu matematiko erraldoi bat sortzen duzu. Hori bai, ondo idatzitako testuak eman behar zaizkio»

Ikasi egiten dute, «baina ez dakigu oso ondo zer ikasten duten», onartu du Soroak. Kutxa beltzekin parekatu ditu. «Ikerkuntza arazo bat dago: jakitea zer demontre dagoen hor barruan eta zer egin hori hobeto kontrolatzeko. Ataza bat ematen diozu, eta ikasi egiten du. Input bat ematen diozu, eta output bat ematen dizu».

Ez dira kontrolatzeko errazak, sistema erraldoiak baitira. Hainbat parametro dituzte. Bi adibide ezagun: GPT-3 hizkuntza ereduak, esaterako, 175.000 milioi parametro ditu; Bert-large-k, berriz, 350 milioi.

Hizkuntza eredu desberdinak; emaitza, antzekoa

Ixa taldeak, EusCrawl osatu eta gero, euskararen bi hizkuntza eredu sortzeko eta entrenatzeko erabili zuen. Hizkuntza eredu horietako bat gaur egun euskararako dagoen eredurik handiena da, 355 milioi parametrokoa. Hizkuntza eredu berri horiek euskarazko beste corpus batzuekin ere entrenatu zituzten: Googleren mC4rekin eta Meta AIren CC100ekin, berez, EusCrawl baino kalitate txarragokoak.

Probetan ikusi zuten baietz, EusCrawlen testuen kalitatea besteena baino hobea zela, baina ezusteko ondorio bat ere atera zuten: hizkuntza eredu guztiei hizkuntzaren prozesamendurako zenbait eginkizun jarri zizkieten, eta emaitzak berdintsuak izan ziren. Alegia, ez zegoen hainbesteko alderik EusCrawlekin entrenatutako eta Googleren eta Meta AIren corpusekin entrenatutako hizkuntza ereduen artean.

Ez zegoen hainbesteko alderik EusCrawlekin entrenatutako eta beste corpusekin entrenatutakoen artean. Ixaren ustez, «horrek erakusten du garrantzitsuagoa dela testuen kantitatea, kalitatea baino».

«Horrek erakusten digu munstro hauek entrenatzeko garrantzitsuagoa dela testuen kantitatea, kalitatea baino», ondorioztatu du Ixak. «Beraz, euskarazko ahalik eta corpusik handiena biltzen saiatu behar dugu, euskarazko tresna eta aplikazio hobeak nahi baditugu».

Euskarazko komunikabide askoren testuak xurgatu dituzte. Handien artean, EITBren edukiak falta dira. Argitaletxeenak ere bai. Eta beste hainbat: sare sozialak... Sare sozialei dagokienez, hizkuntza ereduak hizkuntza horren zenbat eta erregistro gehiago izan, orduan eta eredu aberatsagoa da.

«Hala ere», ohartarazi du Soroak, «euskararen corpus ezagun guztiak bilduta ere, hizkuntza nagusien tamainatik oso urrun geratuko ginateke, eta horrek euskarazko hizkuntza ereduei goi borne bat ezartzen die». Arriskua: euskararentzat sor daitezkeen tresnen kalitatea ez izatea ingelesarentzat sortzen direnen parekoa, esaterako.

«Euskararen corpus ezagun guztiak bilduta ere, hizkuntza nagusien tamainatik oso urrun geratuko ginateke, eta horrek euskarazko hizkuntza ereduei goi borne bat ezartzen die».

Egoera horri aurre egiteko, Ixak bi helburu estrategiko ezarri ditu: batetik, corpus handiagoak biltzea, euskarazko testu ekoizle guztien edo gehienen testuak erabili ahal izatea; bestetik, testu gutxiagorekin ikasteko gai izango diren hizkuntza ereduen ikerketa bultzatzea, hizkuntza gutxitua izatearen mugei aurre egin ahal izateko. Beste herrialde batzuetan ikertzaileei lizentzia librerik gabeko testuak erabiltzen uzten diete, corpusak osatzeko, teknologia horien garapena lehentasuna baita.

Jatorrizko artikuluak

-

Euskara ona makinentzat

Jakes Goikoetxea |

|

|